ファインチューニングのための

Weights & Biases

重みとバイアスで大規模モデルのトレーニングと微調整を行う世界クラスの AI チームに参加して、最高の AI を構築しましょう。

の世界をリードする ML チーム 信頼Weights & Biases

重みとバイアス は、LLM、拡散モデル、またはマルチモデル:

Hugging Face トランスフォーマーと TRL ライブラリには、実験の追跡を有効にするための強力な統合が備わっています。 開始方法については、Transformers のドキュメントを参照してください。 例

コード:

# 1. Define which wandb project to log to

wandb.init(project="llama-4-fine-tune")

# 2. turn on model checkpointing

os.environ["WANDB_LOG_MODEL"] = "checkpoint"

# 3. Add "wandb" in your `TrainingArguments`

args = TrainingArguments(..., report_to="wandb")

# 4. W&B logging will begin automatically when your start training your Trainer

trainer = Trainer(..., args=args)

# OR if using TRL, W&B logging will begin automatically when your start training your Trainer

trainer = SFTTrainer(..., args=args)

# Start training

trainer.train()

Axolotl は Hugging Face トランスフォーマー トレーナーに基づいて構築されており、LLM 微調整用に最適化された多くの追加変更が加えられています。以下の wandb 引数を config.yml ファイルに渡して、W&B ログを有効にします。 コード:

# pass a project name to turn on W&B logging

wandb_project: llama-4-fine-tune

# "checkpoint" to log model to wandb Artifacts every `save_steps`

# or "end" to log only at the end of training

wandb_log_model: checkpoint

# Optional, your username or W&B Team name

wandb_entity:

# Optional, naming your W&B run

wandb_run_id:

さらに高度な W&B 設定を使用することもできます。

ここで追加の環境変数を設定します

.

Lightning は、わずか数行でトレーニングを開始できる強力なトレーナーです。開始するには、 W&B Lightning ドキュメントとLightning ドキュメントを参照してください。

ここで追加の環境変数を設定することで、より高度な W&B 設定を使用することもできます。

コード:

import wandb

# 1. Start a W&B run

run = wandb.init(project="my_first_project")

# 2. Save model inputs and hyperparameters

config = wandb.config

config.learning_rate = 0.01

# 3. Log metrics to visualize performance over time

for i in range(10):

run.log({"loss": loss})

ここで追加の環境変数を設定することで、より高度な W&B 設定を使用することもできます。

MosaicML の Composer ライブラリは、モデルをトレーニングするための強力なオープン ソース フレームワークであり、LLM Foundry ライブラリの基盤となっています。わずか数行のコードで、Composer との Weights & Biases の統合をトレーニングに追加できます。

詳細については、MosaicML Composer のドキュメントを参照してください。

コード:

from composer import Trainer

from composer.loggers import WandBLogger

# initialise the logger

wandb_logger = WandBLogger(

project="llama-4-fine-tune",

log_artifacts=true, # optional

entity= <your W&B username or team name>, # optional

name= <set a name for your W&B run>, # optional

init_kwargs={"group": "high-bs-test"} # optional

)

# pass the wandb_logger to the Trainer, logging will begin on training

trainer = Trainer(..., loggers=[wandb_logger])

wandb.int引数に追加のパラメータを渡すことで、より高度な W&B 設定を使用することもできますinit_kwargs。また、ここで環境変数を使用して追加の W&B 設定を変更することもできます。

Hugging Face Diffusers は、画像、音声、さらには分子の 3D 構造を生成するための最先端の事前トレーニング済み拡散モデルを提供するライブラリです。

弊社のディフューザー自動ロガーを使用すると、わずか 1 行のコードでディフューザー パイプラインから重みとバイアスへの生成をログに記録できます。

例:

コード:

# import the autolog function

from wandb.integration.diffusers import autolog

# call the W&B autologger before calling the pipeline

autolog(init={"project":"diffusers_logging"})

# Initialize the diffusion pipeline

pipeline = DiffusionPipeline.from_pretrained(

"stabilityai/sdxl-turbo"

)

# call the pipeline to generate the images

images = pipeline("a photograph of a dragon")

GPT-3.5 および GPT-4 の OpenAI の微調整は強力であり、Weights & Biases の統合により、使用されたすべての実験、すべての結果、すべてのデータセット バージョンを追跡できます。

開始方法については、OpenAI Fine-Tuning ドキュメントをご覧ください。

例:

- 重みとバイアスを使って OpenAI の GPT を微調整する

- 質問応答のための ChatGPT の微調整

- Gorilla で ChatGPT-3.5 を微調整すると、API とツールの使用パフォーマンスが向上しますか?

コード:

from wandb.integration.openai import WandbLogger

# call your OpenAI fine-tuning code here ...

# call .sync to log the results from the fine-tuning job to W&B

WandbLogger.sync(id=openai_fine_tune_job_id, project="My-OpenAI-Fine-Tune")

MosaicML は高速で効率的な微調整と推論を提供し、Weights & Biases の統合により、使用されたすべての実験、すべての結果、すべてのデータセット バージョンを追跡できます。

W&B ログを有効にする方法については、MosaicML の Fine-Tuning ドキュメントを参照してください。

コード:

W&B ログを有効にするには、YAML 構成ファイルに以下を追加します。

integrations:

- integration_type: wandb

# Weights and Biases project name

project: llama-4-fine-tuning

# The username or team name the Weights and Biases project belongs to

entity: < your W&B username or team name >

Together.ai は、最新のオープンソース モデルに対して高速かつ効率的な微調整と推論を提供し、Weights & Biases の統合により、すべての実験を追跡できます。

微調整を開始する方法については、Together.ai の微調整ドキュメントを参照してください。

コード:

# CLI

together finetune create .... --wandb-api-key $WANDB_API_KEY

# Python

import together

resp = together.Finetune.create(..., wandb_api_key = '1a2b3c4d5e.......')

コマンドライン インターフェイスを使用する場合は、W&B ログをオンにするために、W&B API キーを引数に渡します。Pythonライブラリwandb-api-keyを使用する場合は、W&B API キーをパラメーターに渡すことができますwandb_api_key。

Hugging Face AutoTrain ライブラリは LLM の微調整を提供します。--report-to wandb引数を渡すことで、W&B ログをオンにすることができます。

コード:

# CLI

autotrain llm ... --report-to wandb

GPT-3.5 および GPT-4 の OpenAI の微調整は強力であり、Weights & Biases の統合により、使用されたすべての実験、すべての結果、すべてのデータセット バージョンを追跡できます。

開始方法については、OpenAI Fine-Tuning ドキュメントをご覧ください。

例:

- OpenAI GPT-3.5 および GPT-4 モデルを微調整する方法

- 質問応答のための ChatGPT の微調整

- Gorilla で ChatGPT-3.5 を微調整すると、API とツールの使用パフォーマンスが向上しますか?

コード:

from wandb.integration.openai import WandbLogger

# call your OpenAI fine-tuning code here ...

# call .sync to log the results from the fine-tuning job to W&B

WandbLogger.sync(id=openai_fine_tune_job_id, project="My-OpenAI-Fine-Tune")

HuggingFace を使用してLLM を微調整する方法を学ぶ

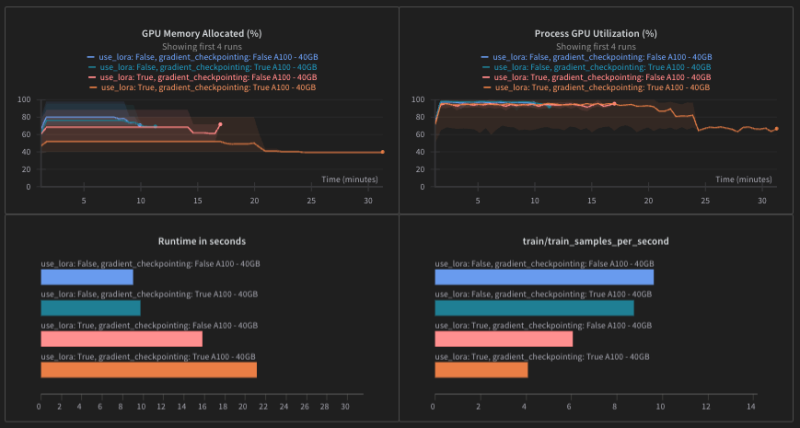

このインタラクティブな重みとバイアス レポートでは、HuggingFace Trainer を使用して LLM を微調整する方法を説明し、LoRA やモデルのフリーズなどのいくつかの一般的な方法を説明します。

最先端の LLM を構築する チームからの信頼

テクノロジー担当副社長

「W&B では、すべてのプロジェクトを簡潔に把握できます。実行を比較し、すべてを 1 か所に集約して、何がうまく機能し、次に何を試すかを直感的に決定できます。」

製品担当副社長 – OpenAI

「私たちはほぼすべてのモデルトレーニングに W&B を使用しています。」

プロダクト マネージャー – Cohere

「W&B を使用すると、すべての候補モデルを一度に検討できます。これは、各顧客にとってどのモデルが最適であるかを理解するために不可欠です。レポートは、私たちにとっても非常に役に立ちました。レポートにより、微妙な技術情報をシームレスに伝達できるようになります。技術者以外のチームにとっても理解しやすいものです。」

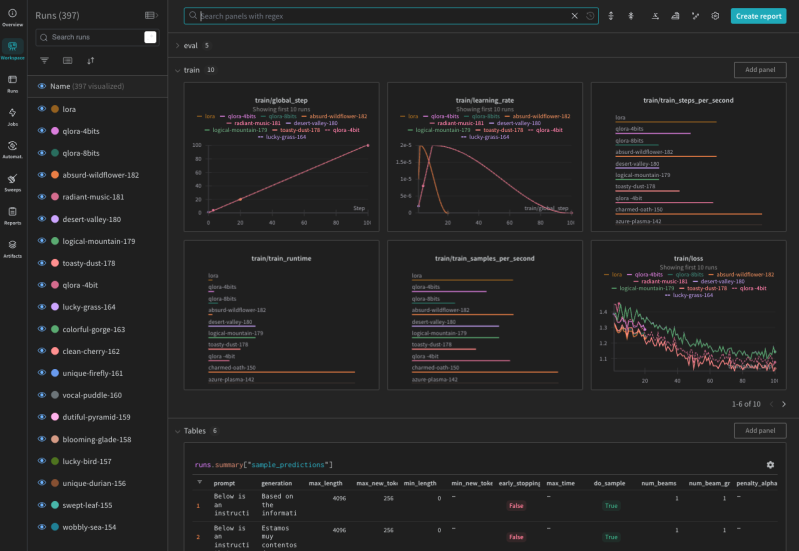

Weights & Biasesの実際の動作を確認する

LLM を微調整する方法 パート 3: HuggingFace Trainer

LLM を微調整する方法 パート 2: Llama 2 の命令チューニング

LLM を微調整する方法 パート 1: 命令チューニング用のデータセットの準備

OpenAI GPT-3.5 および GPT-4 モデルを重みとバイアスで微調整する方法

Azure OpenAI と W&B を使用した法的コパイロットの微調整

ニューロン ハッキング: キーバリュー ストアとして機能するように LLM を微調整できますか?

W&B を使用した Amazon SageMaker のオープンソース LLM の微調整

Weights & Biases プラットフォームは、

ワークフローをEnd-to-Endで効率化します

W&B Models

Experiments

ML実験のトラッキング

と可視化

Sweeps

ハイパーパラメータの

最適化

Registry

モデルとデータセット

の共有と公開

Automations

ワークフローの

自動トリガー

Launch

MLワークフローを

パッケージ化して実行

W&B Weave

Traces

LLMとプロンプトの

記録とトラッキング

Evaluations

生成AIアプリケーション

の評価